https://www.cnblogs.com/happyliu/p/6142929.html

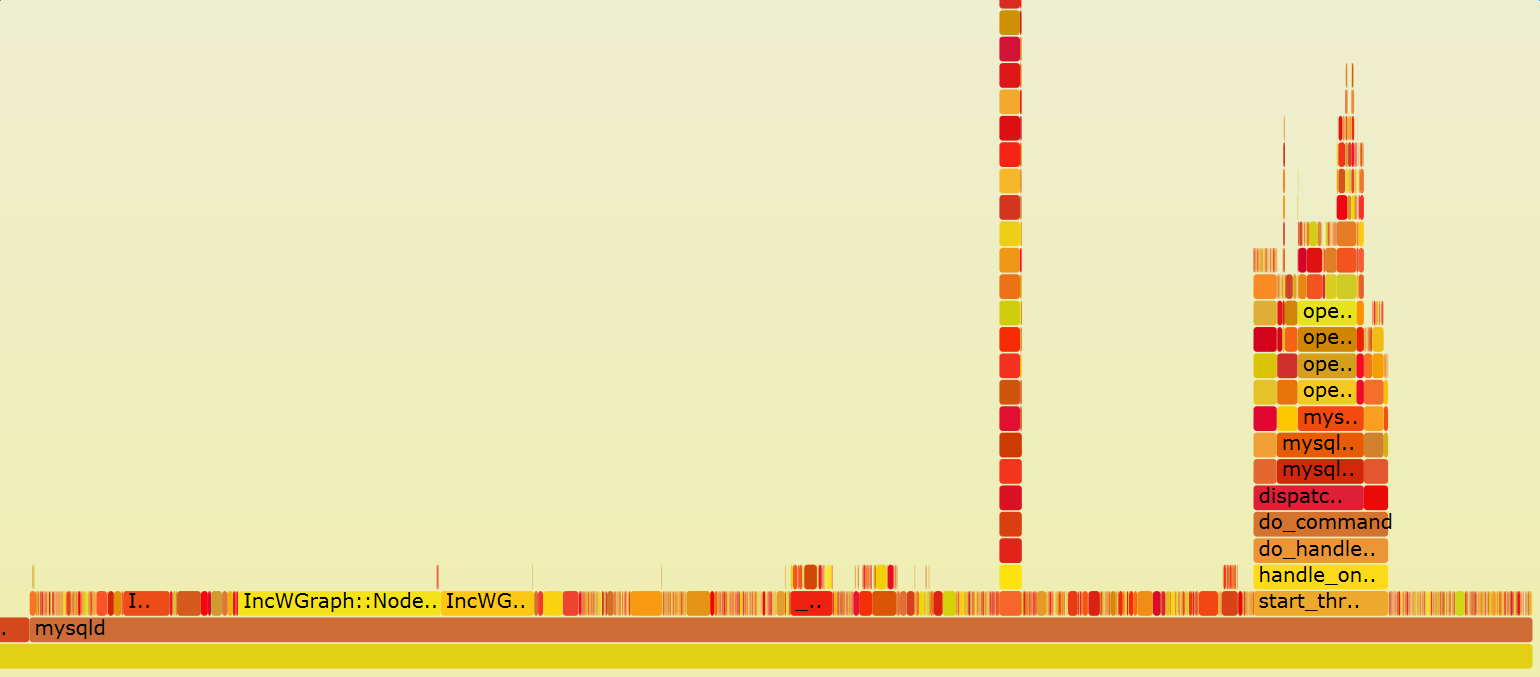

使用火焰图展示结果

1、Flame Graph项目位于GitHub上:https://github.com/brendangregg/FlameGraph

2、可以用git将其clone下来:git clone https://github.com/brendangregg/FlameGraph.git

我们以perf为例,看一下flamegraph的使用方法:

1、第一步

1

| |

Ctrl+c结束执行后,在当前目录下会生成采样数据perf.data.

2、第二步

用perf script工具对perf.data进行解析

1

| |

3、第三步

将perf.unfold中的符号进行折叠:

1

| |

4、最后生成svg图:

1

| |